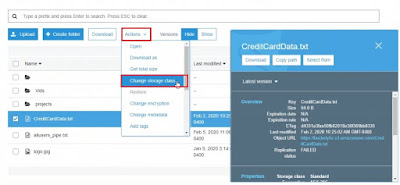

11.1 Configuración de Amazon S3 Glacier

Podemos configurar el almacenamiento de bajo costo a largo plazo con Amazon S3 Glacier.

Una forma de hacerlo es marcar elementos específicos almacenados actualmente en S3 para usar una clase de almacenamiento diferente en forma de depósito Glacier, y otra forma es configurar una regla de ciclo de vida en el depósito para migrar automáticamente los datos más antiguos a Glacier.

Desde la Consola de AWS tecleamos → S3 → (elegimos un bucket S3)

11.2 Tipos de balanceo de carga de AWS

El balanceador de carga de Amazon Elastic, o ELB, es una consideración importante cuando planeamos el uso de aplicaciones en AWS. Una de las razones es que podemos mejorar el rendimiento y otra razón es que podemos aumentar la alta disponibilidad. Esto se debe a que hay varios contenedores backend o instancias EC2 que admiten una aplicación y, por lo tanto, se mejora el rendimiento o se logra una alta disponibilidad. Porque si una instancia de backend, por ejemplo, falla, otras están disponibles para tomar el relevo. ELB también es escalable.

11.3 Implementación del equilibrador de carga de red

Un balanceador de carga de red está diseñado para aumentar la disponibilidad de una aplicación, porque las solicitudes pasan por la interfaz del balanceador de carga y hay un grupo de servidores backend separado en la aplicación. Incluso si una aplicación deja de funcionar, otros servidores o instancias pueden manejar la solicitud. Por lo tanto, aumenta la alta disponibilidad y también el rendimiento. Tenemos más jobs esencialmente sirviendo la aplicación.

Consola → EC2 → (panel izquerdo) Load Balancer → (botón) create Load Balancer

11.4 Grupos de ubicación

En Amazon Web Services, se puede especificar un grupo de ubicación cuando se lanza una nueva instancia, y también se puede cambiar después del hecho, como usar la AWS CLI. Cuando creamos un grupo de ubicación, lo hacemos para poder determinar cómo se distribuyen varias máquinas virtuales o instancias EC2, por ejemplo, en el hardware de los centros de datos de AWS.

Consola → EC2 → (panel izquerdo) Placement Groups→ (Botón) create Placement Group

11.5 Replicación entre regiones de S3

Podemos lograr una alta disponibilidad con el contenido almacenado en un bucket de S3 habilitando la replicación entre regiones, también conocida como CRR.

Para comenzar, desde la Consola de administración de AWS, tecleamos S3 para iniciar la Consola de administración de S3, donde luego vemos una lista de buckets.

Consola → S3 → (elegimos un bucket S3) → Management → replication

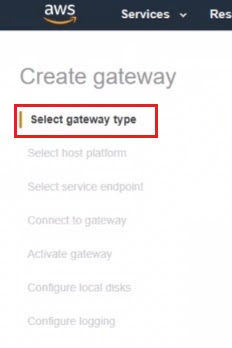

11.6 Gateway de almacenamiento

AWS Storage Gateway es una solución de almacenamiento híbrida. Los servicios locales que podemos tener en ejecución pueden comunicarse con el dispositivo de almacenamiento de AWS e incluso pueden comunicarse con el almacenamiento de AWS a través del dispositivo para acceder a almacenamiento adicional en la nube. Por lo que se puede utilizar como una solución de copia de seguridad en la nube. También es una solución de emulación de cinta en la nube, por lo que parece un dispositivo de cinta para los hosts locales que podrían necesitar realizar una copia de seguridad, cuando en realidad es la puerta de enlace de almacenamiento de AWS la que a su vez almacena esas copias de seguridad en la nube.

Por lo tanto, también podemos usar recursos compartidos de archivos locales respaldados en la nube.

Consola → Storage Gateway → get started

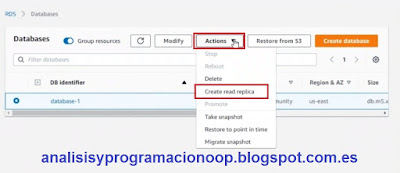

11.7 Réplicas de bases de datos MySQL

En la Consola de administración de AWS, podemos realizar una réplica de una implementación de MySQL existente.

Podríamos hacer esto para implementar nuestra réplica de solo lectura en una ubicación alternativa donde habrá mucho acceso de lectura, como consultas, pero al mismo tiempo significa que también tenemos una copia adicional de los datos replicados actualizados.

Consola → RDS → databases

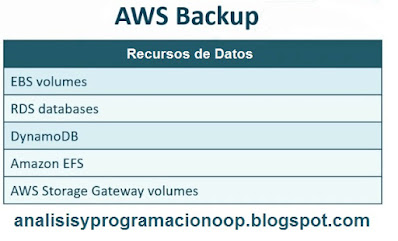

11.8 Copia de seguridad de AWS (AWS Backup)

La solución de respaldo de AWS se basa en el uso de instantáneas, que se toman de una variedad de fuentes diferentes, ya sean locales o en la nube. Y estas instantáneas sirven como copias de seguridad. Las fuentes de respaldo incluyen una variedad de elementos disponibles en AWS, así como aplicaciones locales. La ubicación de almacenamiento predeterminada para los elementos respaldados por AWS se encuentra dentro de los buckets de S3. Los servicios de AWS que se pueden respaldar incluyen volúmenes de EBS, bases de datos RDS, DynamoDB, Amazon EFS y también el volumen de AWS Storage Gateway podemos hacer que los elementos locales estén disponibles para respaldo utilizando AWS Backup para almacenamiento en la nube.

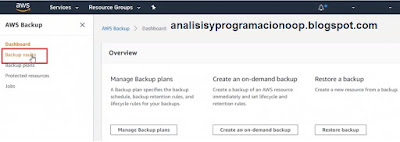

Consola → AWS Backup → Backup vaults → (botón ) Create Backup vault11.9 Copias de seguridad bajo demanda

Una vez que hayamos configurado los planes de copia de seguridad en la copia de seguridad de AWS, que normalmente se programan, podemos, por supuesto, realizar una copia de seguridad bajo demanda en cualquier momento.

Consola → AWS Backup → Backup plans

11.10 Restauración de copia de seguridad de AWS

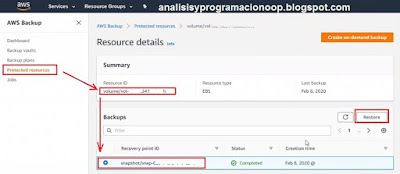

Con el Backup de AWS, podemos crear un plan de respaldo para programar backups de recursos de AWS, podemos copiarlos en regiones alternativas y podemos realizar respaldos bajo demanda.

Consola → AWS Backup → Protected resources

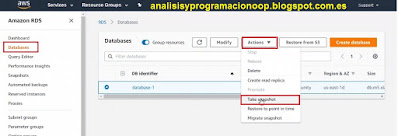

11.11 Instantáneas de la base de datos MySQL

Al igual que podemos tomar una instantánea de un volumen de EBS para su custodia, de modo que podemos volver a usarlo en caso de corrupción o eliminación de datos, podemos hacer lo mismo con una base de datos MySQL: podemos crear una instantánea de la misma.

Consola → RDS → Databases

11.12 Restauración de instantáneas de base de datos

Si hemos tomado instantáneas de bases de datos, podemos restaurarlas en caso de que surja un problema con la base de datos de origen.

12.13 Instantáneas de volumen

Es posible utilizar la Consola de administración de AWS para crear una instantánea de volumen de EBS. ¿para qué haríamos esto? Pues por seguridad. En el caso de que haya algún tipo de corrupción o problema en el volumen de EBS de origen, tenemos una instantánea a la que básicamente podríamos volver.

Incluso podríamos usar esa instantánea como un punto de partida de origen para crear otros volúmenes de EBS, incluso si no hay ningún problema con el volumen de origen.

Consola → EC2 → (menu izqud) Elastic Block store → volumes