Amazon Simple Storage Service (Amazon S3) es un servicio de almacenamiento de objetos que permite escalabilidad, disponibilidad de datos, seguridad y rendimiento. Almacena y protege cualquier volumen de datos para cualquier utilidad como lagos de datos, sitios web, aplicaciones móviles, procesos de copia de seguridad y restauración, operaciones de archivado, aplicaciones empresariales, dispositivos IoT y análisis de big data. Amazon S3 proporciona características de administración fáciles de utilizar que permiten organizar los datos y configurar sofisticados controles de acceso.

14.1 Replicación de S3

Podemos habilitar la replicación entre regiones de bucket S3, o CRR, para una mayor redundancia. Esencialmente para sincronizar el contenido de un depósito S3, o para filtrar qué objetos se replican en un sitio alternativo.

Para gestionarlo desde la consola de AWS escribimos S3 y nos sale

14.2 versionado de S3

El control de versiones de S3 es el tipo de característica que podemos esperar en una solución de administración de documentos, donde se retienen varias versiones de documentos individuales.

Desde la consola ponemos S3 y vamos a Bucket Projects → Versioning

14.3 Creación de un bucket S3

Utilizaremos la GUI de la consola de administración de AWS para crear un cubo (bucket) de S3. Antes de nada necesitamos saber el propósito de este cubo. ¿para alojar un sitio web? ¿Se utilizará para almacenar archivos de productividad de la oficina, como hojas de cálculo y documentos, y diapositivas para los usuarios? ¿Se usará para almacenar copias de seguridad? Y consideraremos cómo configurar el nivel de almacenamiento para el archivado a largo plazo.

Tecleamos S3 en la consola

14.4 Administración del ciclo de vida de S3

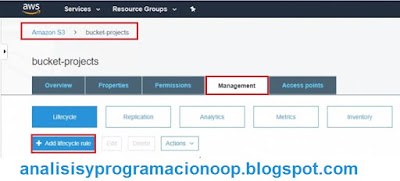

La administración del ciclo de vida del bucket de Amazon S3 utiliza las llamadas reglas de transición para migrar datos de un nivel de almacenamiento a otro, de manera automatizada. Como puede ser coger los datos a los que no se ha accedido en mucho tiempo y moverlos a la clase de almacenamiento Glacier.

Para comenzar con la gestión del ciclo de vida, hay que abrir un cubo.

Desde la consola ponemos Amazon S3 y vamos a Bucket Projects pulsamos sobre el botón Management y luego sobre el botón Add lifecycle rule

14.5 Niveles de almacenamiento S3 (Bucket Storage Tiers)

Podemos usar la Consola de administración S3 para ver y cambiar los niveles de almacenamiento S3 o las clases de almacenamiento para los objetos que hemos almacenado en S3.

Desde la Consola de administración S3 elegimos S3 Bucket

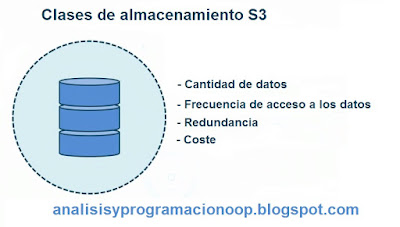

14.6 Clases de almacenamiento S3

Para decidir una clase de almacenamiento, tenemos que considerar cosas como la cantidad de datos que se almacenarán en S3. La frecuencia con la que se necesita acceder a los datos, la clase de almacenamiento y su redundancia, si necesitamos múltiples copias. Hay varias clases diferentes de almacenamiento S3.

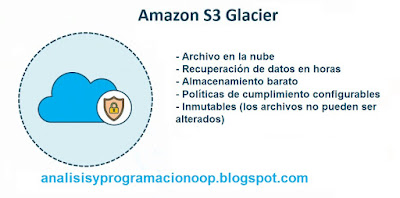

14.7 Amazon S3 Glacier

Amazon S3 Glacier es una solución de archivos en la nube de AWS, la recuperación de datos de un archivo Glacier puede llevar de minutos a horas. Podemos especificar recuperaciones aceleradas como opción. Podemos acceder a los datos entre uno a cinco minutos en función de una cierta tasa de la cantidad de datos que se recuperan. Se considera un medio de almacenamiento económico para los datos a los que se accede con frecuencia en la nube. Es la opción que elegiremos si necesitamos acceder a los datos una o dos veces al año y nos da igual necesitar entre 12 y 48 horas para la recuperación de estos.

14.8 Aceleración de transferencia S3

Como su nombre lo indica, el uso de la aceleración de transferencia S3 acelera las transferencias de archivos a un depósito S3. Esto se logra aprovechando la red de entrega de contenido de Amazon CloudFront, o CDN, donde los datos se copian o almacenan en caché en diferentes puntos finales geográficos de todo el mundo.

hacemos clic en un cubo existente en la Consola de administración S3.

14.9. Volúmenes de la almacenamiento de bloques elásticos (Elastic Block Store Volumes.)

Los volúmenes de Elastic Block Store o EBS

son similares a los discos duros virtuales que pueden asociarse con máquinas virtuales.

Para comenzar a crear un volumen EBS, en la consola de administración de AWS, tecleamos EC2, y en Todos los servicios -> Computar.

Se abre una página web llamada "Consola de administración EC2". Se divide en dos partes: panel de navegación y panel de contenido.

14.10 Adjuntar volúmenes a instancias EC2

Después de crear un volumen EBS, podemos adjuntarlo a una instancia EC2.

Se abre la Consola de administración EC2 en la que se abre la página Volúmenes.

En la Consola de administración EC2, navegamos hasta la vista de volúmenes de Elastic Block Store.

14.11 Configurar el sistema de archivos elástico

En Amazon Web Services, Elastic File System, o EFS,

es esencialmente una carpeta compartida en la nube a la que puede conectarse desde dispositivos locales o desde instancias EC2 que se ejecutan en la nube de AWS. Lo que es, es un recurso compartido NFS al que nos conectamos, por ejemplo, incluso desde un host Linux, usando el comando mount.

Buscamos EFS en la consola elegimos un resultado en la lista de búsqueda. Y pulsamos el botón Crear sistema de archivos.

Depués hacemos clic en el botón "Crear sistema de archivos" y se muestra su asistente correspondiente.