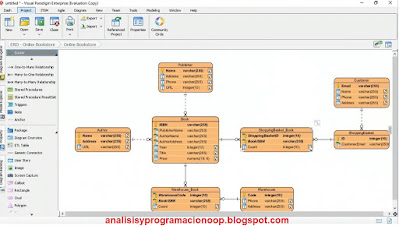

En esta demostración, veremos una herramienta que nos ayudará a crear un diagrama de relación de entidades, o ERD, para planificar la estructura de la base de datos. La herramienta se encuentra en el enlace https://www.visual-paradigm.com en un navegador, vamos a este sitio web donde hacemos clic en el enlace Download para descargar una prueba gratuita de 30 días. Entramos en la interfaz de Visual Paradigm, donde las pestañas de la parte superior identifican diferentes categorías de diagramas que podríamos querer crear con esta herramienta. Por ejemplo, ERD, que son diagramas de relación de entidades. Aunque si nos desplazamos hacia abajo, también tenemos otras opciones disponibles enumeradas a la derecha. Hacemos clic en la opción ERD. Aparece una nueva ventana con el encabezado Diagrama de relaciones entre entidades.

Tiene las siguientes opciones: En blanco, Álbum de fotos en línea, Alquiler de películas, etc. En la parte inferior están los botones, Next y Cancel. Podemos construir un diagrama de relación de entidades en blanco, o elegir una de las plantillas preexistentes, por ejemplo, si nos desplazamos hacia abajo, podemos elegir Bookstore Online. Podemos utilizar esta plantilla porque solo deseamos modificarla, y eso puede ser más rápido que construirla desde cero. La seleccionamos y hacemos clic en Siguiente. Le ponemos un nombre, y aceptamos. hacemos clic en el botón Next. Se abre el diagrama de tablas de la librería en línea.

En el diagrama tenemos varias entidades o tablas. Esto define una estructura de base de datos. Por ejemplo, en la tabla Publisher, tiene una serie de columnas como Name, Adress, Telephone, URL. Podemos realizar cambios en cualquiera de estos elementos. Por ejemplo, si hacemos doble clic en el nombre de una tabla en la parte superior, la selecciona y podemos escribir un nombre nuevo.

También podemos agregar nuevos elementos. Y también si estamos construyendo un diagrama de relación de entidades desde cero, podemos hacer clic con el botón derecho y hacer todo manualmente. Si hacemos clic derecho sobre una parte vacía del diagrama, y elegimos add Shape y luego Entity. De modo que se crea una nueva entidad (futura tabla de una base de datos)

Una vez creada la tabla podemos definir columnas las columnas, si hacemos clic derecho dentro de esa tabla, podemos elegir New Column.

Si hacemos clic derecho sobre la columna y elegimos Open Specification sale una lista desplegable donde podemos elegir por ejemplo el tipo de datos de la columna.

También podemos hacer clic derecho sobre él y configurarlo como clave principal.

Incluso tenemos la opción, de vincular estas columnas para establecer una relación. Por ejemplo, si colocamos el cursor sobre una tabla existente como Publisher.

Contiene un icono que podemos usarlo para arrastrar una línea a la otra tabla. Y determinar si existe una relación de uno a uno con las filas de cada una de esas tablas, o de uno a muchos. Digamos que es uno a muchos. Aparece una ventana emergente con 4 opciones de iconos de vinculación como: Relación uno a uno, Relación uno a muchos, etc. Hacemos clic en el icono que nos interese (en este caso Relación uno a muchos) y aparece una ventana de especificación de relación.

Tiene dos pestañas: Foreign Key Column Mapping (Asignación de columna de clave externa) y General, donde se selecciona Asignación de columna de clave externa. Ahora, determinamos las columnas específicas que queremos vincular. Debajo en el combo se nos muestra la lista de columnas que podemos vincular con la clave principal en la tabla de Publisher, y podemos determinar a qué columna queremos vincular nuestra tabla.

Podemos continuar con esto en el diseño de la estructura para nuestro almacenamiento de datos, y esto es parte de la arquitectura de datos. Hay muchas otras herramientas que hacen esto además de Visual Paradigm.

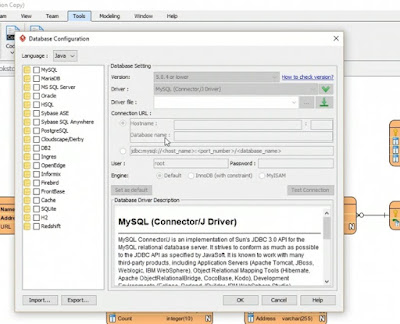

Si vamos al menú Herramientas en la parte superior y luego elegimos DB para base de datos. Y luego elegimos Configuración de la base de datos, podemos decirle que queremos hacer una conexión a un tipo específico de base de datos.

Digamos que elegimos .NET como idioma, y Microsoft SQL Server. Podemos especificar el nombre del host. Así que la identidad de ese servidor a través de la red con un nombre de usuario y contraseña y prueba la conexión.

A la derecha está la Configuración de la base de datos con varias opciones. Nombre de la base de datos, nombre de usuario y contraseña. Justo debajo, hay un botón llamado Probar conexión. (test Connection) Nos encontraremos con muchas de estas herramientas no solo nos permitirán diagramar la relación entre nuestras entidades, las tablas de nuestra base de datos. En realidad, crearemos un sistema de base de datos dado, ya sea MySQL, Microsoft SQL Server, Oracle, DB2, etc. Por lo tanto, es importante tener una herramienta para realizar varios tipos de planificación de la arquitectura de datos en la empresa.