Existe un período de tiempo en el que los datos tienen utilidad para una organización, y esto se denomina ciclo de vida de los datos. Se refiere a la vida útil que tienen los datos y está dividido en varias fases diferentes. La gestión de datos debe aplicarse a cada fase, por lo tanto, debemos asegurarnos de gestionar los datos correctamente desde su inicio, su creación, hasta su eventual desmantelamiento o eliminación. Y a menudo tenemos que hacer esto para el cumplimiento legal y regulatorio. Por supuesto, también debemos asegurarnos de cumplir con las pautas de gestión de la política de datos de la organización. Las políticas de seguridad también dictarán cómo se tratan los datos a lo largo de su vida útil. El ciclo de vida de los datos, que se enumera aquí, comienza con la creación. después, el almacenamiento, uso e intercambio de datos.

Crear

La creación de datos puede presentarse de muchas formas diferentes. Por ejemplo recopilación de datos. Ya sea a través de formularios on-line o físicos que escaneamos. Realizando encuestas, métricas para anuncios que pueden rastrear ciertas preferencias de un usuario y luego mostrar los anuncios adecuados. Métricas de dispositivos de IoT que se envían de vuelta a un repositorio central. Incluso las cookies del navegador web se pueden utilizar para recopilar datos sobre las preferencias del usuario y los sitios visitados. Incluso cosas como el escaneo de códigos de barras para fines de control de inventario. Podemos automatizar acciones relacionadas con la creación de datos.

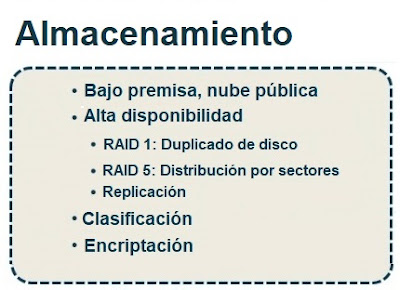

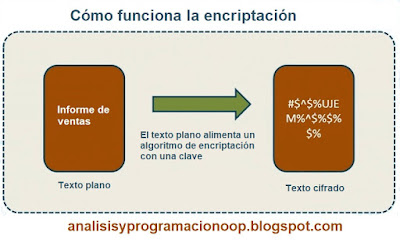

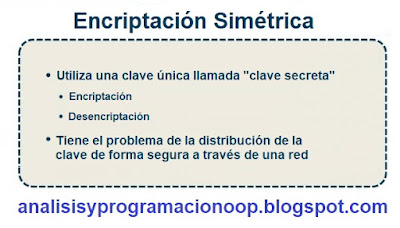

La clasificación de datos también es importante para organizar los diferentes tipos de datos a los que tenemos acceso. Y también pueden relacionarse con los datos con los que deben archivarse o qué datos deben almacenarse en los medios de almacenamiento más rápidos. También es importante saber que datos necesitan cifrado. Podemos automatizar el cifrado de datos, de modo que a medida que introducimos los datos en la nube, se cifren automáticamente. También podemos hacerlo localmente encriptando una carpeta de Windows utilizando un sistema de encriptación.Almacenar

Una de las consideraciones para el almacenamiento es la accesibilidad a los datos. La alta disponibilidad significa que los datos están disponibles cuando se necesitan. Y eso se puede lograr de muchas formas diferentes, como mediante el uso de técnicas de organización de disco, como RAID 1. El nivel 1 de RAID se denomina duplicación de disco. Requiere al menos dos discos, donde todos los datos que se escriben en una partición de disco también se reflejan o se escriben en el segundo disco. Así que siempre tenemos una segunda copia de los datos actualizados. También podríamos habilitar RAID 5, que requiere un mínimo de tres discos, donde tenemos bandas de discos con paridad distribuida. De modo que cuando se escriben datos en la matriz de discos RAID 5, los datos están divididos en trozos más pequeños escritos en esos discos. Tenemos varios discos trabajando juntos como uno. La paridad distribuida significa que la información de recuperación se escribe en una variedad de diferentes discos dentro del sistema RAID 5. Y puede tolerar la falla de un disco.

También podríamos proporcionar alta disponibilidad de datos a través de la replicación. Al replicar los datos en otra ubicación, tenemos esos datos disponibles allí. Ahora, la pregunta es ¿Con qué frecuencia estamos replicando datos entre estos diferentes conjuntos de réplicas? El almacenamiento también incluye la clasificación de datos, como comentamos, para organizar nuestros datos. Que también se puede utilizar para asignar permisos a datos clasificados de cierta manera. Y tenemos que pensar en el cifrado de datos que están en reposo o en medios de almacenamiento, utilizando una variedad de algoritmos de cifrado. Es posible que tengamos que usar un tipo específico de algoritmo de cifrado, como AES-256, para cumplir con ciertas regulaciones.Utilizar

Debemos adherirnos al principio de privilegio mínimo, o PoLP, donde solo se asignan los permisos necesarios para realizar una función de trabajo para el uso de datos, y nada más. También podemos auditar el uso de datos para determinar si se está abusando de los privilegios, si los privilegios se están utilizando correctamente o si necesitamos otorgar o revocar permisos. Solo lo sabremos si auditamos datos a lo largo del tiempo.

También podemos configurar la prevención de pérdida de datos o políticas DLP. Las políticas de DLP generalmente requieren un agente de software en los dispositivos del usuario que monitorea cómo se manejan los datos confidenciales. Y evita que, por ejemplo, se envíe fuera de la empresa a través del uso de las redes sociales o mediante archivos adjuntos de correo electrónico. El uso también incluye resumir datos en informes.

Compartir

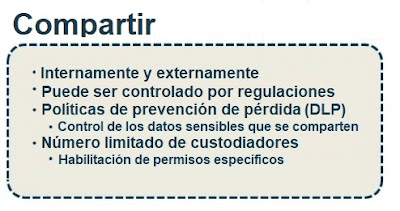

Puede ser interna o externamente. Por ejemplo, podríamos tener datos que deben compartirse en un servidor de archivos con acceso controlado a algunos empleados dentro de la organización. O podríamos compartir datos externamente, con datos clasificados como públicos. También podemos controlar nuestro intercambio utilizando las leyes de privacidad de datos como pautas y regulaciones. Las políticas de prevención de pérdida de datos, o DLP, se aplican nuevamente a la fase de uso compartido. Queremos asegurarnos de que estamos compartiendo datos de manera adecuada, solo con las partes que deberían tener acceso a esos datos. Por lo tanto, debemos controlar el intercambio de información confidencial, como información de identificación personal, PII o información médica protegida, PHI.

Y nuevamente, eso suele estar bajo el paraguas de las regulaciones que determinan cómo se recopilan, usan y comparten esos datos. Por lo tanto, también podemos limitar la cantidad de custodios de datos, aquellos administradores de datos que tienen acceso a los datos y controlan los permisos. Por lo tanto, la custodia de datos establece permisos sobre los datos de acuerdo con las políticas de seguridad de la organización.Archivar

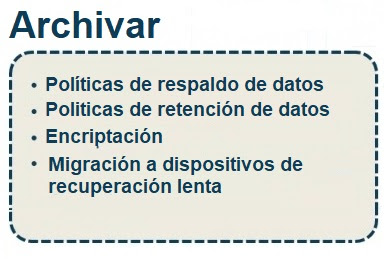

Debemos establecer políticas de respaldo de datos. También contamos con políticas de retención de datos que pueden estipular que la copia de seguridad o el archivo de datos a largo plazo se realice en un medio de almacenamiento diferente al de la copia de seguridad de datos normal. Quizás la copia de seguridad de datos regular vaya a la biblioteca de copias de seguridad en cinta de red del área de almacenamiento. Mientras que la retención o el archivo de datos a largo plazo pueden ir a la nube en medios de almacenamiento lentos, ya que no se accede a ellos con frecuencia. También tenemos que determinar si los datos archivados están encriptados o no para su custodia, y eso podría ser requerido por leyes o regulaciones.

La migración de datos a medios de almacenamiento de rendimiento lento puede ser un proceso automatizado. Por lo tanto, podemos implementar políticas que digan, por ejemplo, que queremos mover datos a los que no se ha accedido en 60 días a medios de almacenamiento más lentos. De este modo liberando espacio para un rendimiento más rápido.

Eliminar

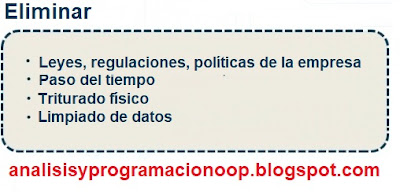

Consiste en la eliminación de los datos una vez que han llegado al final de su vida útil los datos deben ser eliminados. Esto tiene que hacerse de acuerdo con las leyes, regulaciones y políticas organizacionales que pueden tener reglas que determinen qué período de tiempo debe transcurrir antes de que los datos se puedan eliminar de forma permanente. Este lapso de tiempo es muy importante. Además, tenemos que considerar cómo se eliminan esos datos. Incluso puede ser necesaria la destrucción física de dispositivos de almacenamiento.