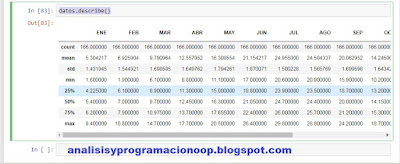

Aquí se puede ver otro ejemplo de conjunto de datos

sábado, 14 de noviembre de 2020

Crear un set de pruebas para Machine Learning

Aquí se puede ver otro ejemplo de conjunto de datos

sábado, 7 de noviembre de 2020

AWS in a nutshell 5: Procesamiento y análisis de datos

5.1 Transcodificador de Amazon Elastic

El servicio de transcodificador elástico en AWS

tiene que ver con el procesamiento de vídeo en la nube. Básicamente, es la manipulación en origen de archivos multimedia para dar como resultado algún tipo de archivo multimedia de salida diferente. Esto permite la reproducción de medios en una amplia variedad de dispositivos donde podríamos modificar el tamaño, el tipo o formato de archivo de los medios, y también la calidad en términos de audio y vídeo. Hay muchos tipos diferentes de formatos de destino que podemos usar con Elastic Transcoder. Algunos de los cuales incluyen MP4, audio FLAC, GIF animados, MP3, audio y vídeo H.264 y muchos otros formatos. Para trabajar con Elastic Transcoder, necesitamos una canalización de transcodificación y también necesitamos dos cubos

Podemos acceder desde la consola de AWS tecleando Elastic transcoder → create a New Pipeline

Finalmente damos al botón Create Pipeline y Create New Job

5.2 Amazon Kinesis

Amazon Kinesis es un servicio de análisis en la nube en tiempo real. Está diseñado para traer datos en tiempo real, por lo que el procesamiento del flujo de datos y con la recopilación y el análisis de datos en tiempo real, tenemos la capacidad de permitir que los tomadores de decisiones estén informados más rápidamente para tomar buenas decisiones. Estos datos pueden provenir de muchas fuentes diferentes, incluidas las fuentes de redes sociales, transacciones financieras o podría ser el resultado de datos de clics de un sitio web. Según dónde hacen clic los usuarios y qué visitan cuando están en un sitio web determinado.

Accedemos desde Consola de AWS → Kinesis → Get started -> Create Data Stream

5.3 Clústeres de Elastic MapReduce

Los clústeres de Elastic MapReduce son colecciones de instancias de Linux. Estos no aparecerán si vamos a la consola EC2. Pero son instancias EC2 de Linux a las que podemos acceder mediante SSH, si necesitamos administrarlas.

El clúster para la reducción de mapas elásticos es útil para el análisis de grandes cantidades datos, big data.

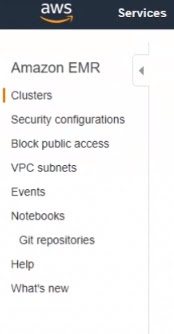

Accedemos desde

Consola AWS → EMR → Create Cluster

5.4 Amazon Rekognition

Amazon Rekognition, tiene que ver con el análisis facial en imágenes y videos, y hay beneficios obvios para las fuerzas del orden y la seguridad aeroportuaria. Pero también desde la perspectiva del marketing, tal vez determinar las emociones de las personas en función de las imágenes cargadas.

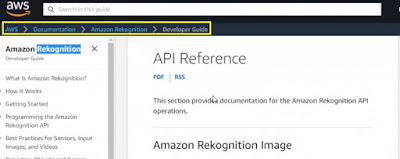

Consola → Amazon Rekognition

5.5 Amazon Elasticsearch

Como su nombre lo indica, Amazon Elasticsearch es un mecanismo de búsqueda en la nube donde los desarrolladores pueden realizar llamadas a la API. Por ejemplo, usando Node JS o usando el comando Linux Curl que está integrado en Mac OS y Linux para cargar archivos en un dominio Elasticsearch, cargamos archivos y se indexan para que el resultado se pueda buscar, Por ejemplo, utilizando la herramienta curl integrada de Linux. También podemos descargarlos y ejecutarlos en Windows utilizando un verbo de puerto HTTP. Ahora, lo que sucede es que la indexación da como resultado un documento JSON.

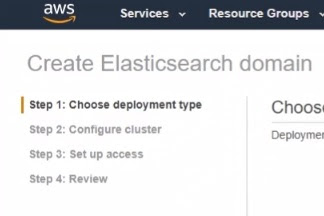

Consola → Elasticsearch Service → create a new Domain

5.6 Amazon Athena

Amazon Athena es un servicio de consulta de macrodatos. Está diseñado para consultas SQL muy rápidas que podrían usarse para análisis de datos. Los datos de origen pueden provenir de una multitud de fuentes, como S3 o AWS Glue. AWS Glue es un servicio de AWS administrado que está diseñado para la extracción, transformación y carga de datos en otros servicios. Donde extraer transformar una carga a menudo se denomina ETL. Trabajar con Athena comienza con obtener datos, por ejemplo, en S3, y luego crear una tabla externa en Athena para albergar esos datos para después escribir una consulta en ellos. Hay varios servicios de big data disponibles en AWS.

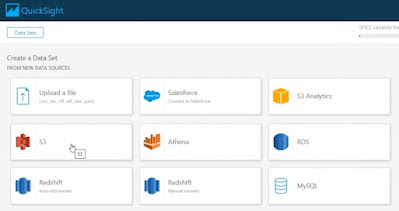

5.7 QuickSight

Amazon QuickSight es una herramienta diseñada para analistas comerciales y de análisis de datos que proporciona visualizaciones, una vez que nos hemos registrado para obtener una cuenta, esta es la página de destino de QuickSight. Podemos iniciarlo desde la Consola de administración de AWS simplemente buscando QuickSight.

Consola → QuickSight

sábado, 31 de octubre de 2020

Tratamiento y visualización de ficheros con Python

Leer y visualizar un fichero .csv

Para dividir el dataset en dos partes, una de

entrenamiento y otra de pruebas

#dividimos el dataset en dos, uno de entrenamiento con el 80% de los

datos y otro de testeo con el 20%.

#Random state es una semilla aleatoria

from sklearn.model_selection import train_test_split

train_set, test_set =

train_test_split(datos,

test_size=0.2,

random_state=42)

Seleccionar y entrenar el modelo

#tomamos como entrenamiento desde el principio hasta el297 y como tets

desde el 297 hasta el final

X_train, X_test, y_train, y_test = X[:297], X[297:], y[:297], y[297:], AÑO

lunes, 26 de octubre de 2020

AWS in a Nutshell 4: Criptografia y PKIs

La criptografía existe para proteger los datos. Proporciona confidencialidad de los datos para garantizar que solo las partes autorizadas puedan ver la información confidencial. Proporciona integridad para que podamos estar seguros de que los datos no han sido manipulados. Y también autenticación de origen para que podamos estar seguros de que los datos provienen de quien dice que provienen. La integridad y la autenticación vienen en muchas formas, como el hash de archivos que se utiliza para verificar la integridad de los archivos. Firmas digitales de correo electrónico, que utilizan hash y autenticación para verificar que un mensaje proviene de quien dice que proviene.

4.1 Infraestructura de Clave Pública

La infraestructura de clave pública, o jerarquía PKI, es una jerarquía de certificados de seguridad digital. Estos certificados son emitidos y administrados por autoridades de certificación, que también se denominan CA. Hay CA privadas que se pueden configurar dentro de una organización para emitir certificados privados. Y también hay CA públicas disponibles en Internet que hacen lo mismo. La diferencia es que los dispositivos confiarán automáticamente en las CA públicas y en los certificados que emitan, donde no confiarán automáticamente en los certificados emitidos por una CA privada.

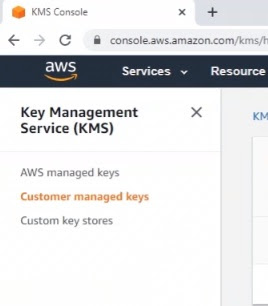

4.2 Descripción general del servicio de administración de claves

El Servicio de administración de claves de AWS, también denominado KMS, está diseñado para facilitar el uso de claves con los servicios de AWS. Las claves se pueden utilizar para cifrado y firma digital. AWS Key Management Service también admite módulos de seguridad de hardware compatibles con FIPS 140-2 o HSM. Un HSM es un dispositivo de hardware a prueba de manipulaciones que está diseñado para el almacenamiento seguro de secretos criptográficos.

4.3 Creación de una clave KMS

En esta demostración, usaremos la Consola de administración de AWS para crear una clave KMS.

Desde la consola de AWS ponemos kms

4.4 Cifrado de volumen EBS

Podemos utilizar AWS para cifrar los volúmenes de EBS que utilizan las instancias EC2.

Por supuesto, dentro del sistema operativo de la instancia, también podemos habilitar el cifrado de volumen de disco completo.

Consola → EC2 → Elastic Block Store → Volumes → Create volume

4.5 Módulos de seguridad de hardware

Un módulo de seguridad de hardware, o HSM, como su nombre lo indica, es una pieza de hardware diseñada para almacenar claves secretas criptográficas. Ahora también ofrece soluciones a prueba de manipulaciones. Y almacena las claves de tal manera que no se pueden manipular sin registrarnos en alguna parte. Los módulos de seguridad de hardware también se pueden configurar o implementar a través de AWS Cloud HSM.

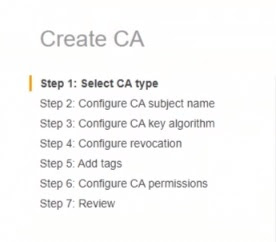

4.6 Descripción general del administrador de certificados

AWS Certificate Manager, o ACM, es una PKI o solución de infraestructura de clave pública en la nube de AWS y es un servicio administrado. Lo que significa que no tenemos que preocuparnos por la configuración subyacente. Se utiliza para la administración de certificados PKI públicos, así como para la administración de certificados PKI privados. Lo que hay que pensar con ACM es que podemos implementar y administrar una autoridad de certificación privada, o CA, donde los certificados no son confiables de forma predeterminada.

4.7 Configuración de CA privada

En una infraestructura de clave pública, las autoridades de certificación se utilizan para emitir certificados PKI. Y podemos implementar una CA privada directamente a través de la Consola de administración de AWS.

Para acceder desde AWS entramos en la consola y ponemos:

acm → private certificate authority y pulsamos en Get started

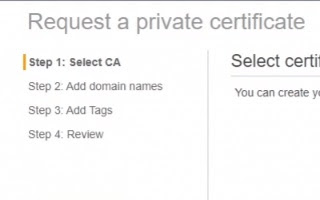

4.8 Solicitar un certificado privado

Para solicitar un certificado privado desde la consola escribimos acm → certificate manager

Y elegimos certificado privado

4.9 Solicitudes de certificados públicos

Para solicitar un certificado público desde la consola

escribimos acm → certificate manager

Consola → acm → certificate manager

Elegimos certificado público

4.10 HTTPS y el balanceador de carga de aplicaciones

En esta demostración, habilitaremos un equilibrador de carga HTTPS.

Antes de que podamos hacer eso, primero necesitamos un certificado PKI que se utilizaremos para asegurar la conexión usando HTTPS en el puerto 443. Echemos un vistazo a algunos elementos existentes que ya están en su lugar. Vamos a la consola de administración de EC2, donde ya tenemos instancias de Windows en funcionamiento que admitirán la aplicación web.

Los pasos a seguir son:

Consola → Ec2 → instancias

Consola → acm → certificados

Consola → Ec2 → Load Balancers → create → aplication Load Balancer