Vamos a realizar un vistazo rápido de los principales proveedores de equipos y servicios bigdata que actualmente operan en el mercado, con el objetivo de evaluar las ventajas e inconvenientes de cada operador y al mismo tiempo tener una visión general del estado actual de la oferta para Bigdata.

Actualmente las organizaciones requieren soluciones de gestión de datos para análisis que sean capaces de gestionar y procesar los datos internos y externos de diversos tipos en diversos formatos, en combinación con datos de fuentes internas tradicionales. Los datos pueden incluso incluir la interacción y los datos de observación, procedentes del internet de las cosas, sensores, por ejemplo. Este requisito constituye un reto para el software en este mercado ya que los clientes están buscando características y funciones que representan un aumento importante de las estrategias de almacenamiento de datos empresariales existentes.

El almacenamiento de datos y soluciones de gestión de datos para el análisis, (DMSA) son sistemas que realizan el procesamiento necesario para soportar la analítica. Estos pueden ser extendidos para soportar nuevas estructuras y tipos de datos, tales como XML, texto, documentos y datos geoespaciales, y el acceso a sistemas de archivos gestionados externamente. Deben apoyar la disponibilidad de datos de software de aplicación de interfaces independientes, incluir mecanismos para aislar los requisitos de carga de trabajo, y controlar diversos parámetros de acceso del usuario final dentro de los casos administrados de datos.

Estos son los requisitos necesarios para este tipo de sistemas.

• Un almacén de datos puede formar parte de un sistema más amplio que sirve de DMSA más amplio.

• Un DMSA es simplemente un sistema para el almacenamiento, el acceso y la entrega de los datos destinados a un caso de uso principal que soporta la analítica.

• Un DMSA no es una clase o tipo de tecnología específica.

• Un DMSA puede consistir en muchas tecnologías diferentes en combinación. Sin embargo, cualquier sistema debe disponer de la capacidad de proporcionar acceso a los archivos o tablas bajo la gestión de herramientas de acceso libre.

• Un DMSA debe ser compatible con la disponibilidad de datos de software de la aplicación de interfaces independientes, incluir mecanismos para aislar los requisitos de carga de trabajo y controlar diversos parámetros de acceso del usuario final dentro de la administración de datos.

• Un DMSA debe gestionar el almacenamiento y acceso de datos en algún tipo de medio de almacenamiento, que puede incluir (pero no se limita) unidades de disco duro, memorias flash, unidades de estado sólido e incluso DRAM.

A continuación pasamos a realizar una breve evaluación por separado de cada sistema.

1010data

1010data es un proveedor de servicios de almacenamiento de datos gestionado. Su solución integrada DBMS e inteligencia de negocio (BI) está dirigido a sectores de servicios financieros, venta al por menor/bienes de consumo envasados, telecomunicaciones, gobierno y salud.

Ventajas

• Facilidad de uso de 1010data para el análisis interactivo, específicamente su rendimiento en las consultas, facilidad de carga de datos y capacidades analíticas.

Inconvenientes

• 1010data tiene un enfoque limitado en el almacén de datos lógicos (LDW). Se centra principalmente en el apoyo a las necesidades de análisis de datos gestionados en su propia nube.

Inconvenientes

• 1010data está todavía basado principalmente en Estados Unidos. Sin embargo, recientemente ha inaugurado un centro de datos en Alemania para operaciones en Europa.

• La integración global de 1010data con su ecosistema de BI y análisis, acceso a datos e integración, requiere una mejora.

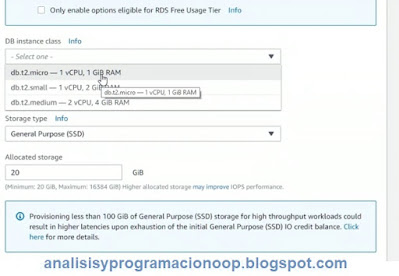

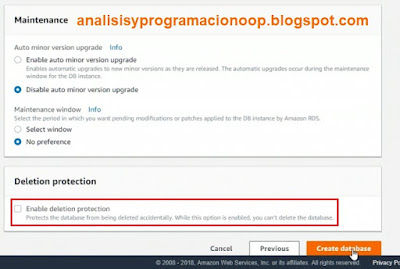

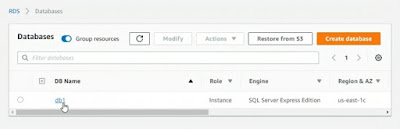

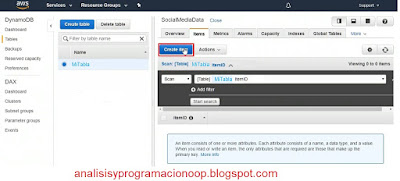

Amazon Web Services

Amazon Web Services (AWS) ofrece un servicio de almacenamiento de datos en la nube, AWS Kinesis para la transmisión de datos, Amazon Simple Service) y Amazon Elastic MapReduce (EMR).

Ventajas

• AWS es considerado el proveedor de almacén de los principales datos en la nube como un servicio. Logra una adopción fuerte, impulsada por su amplia aceptación de la nube, flexibilidad y agilidad, tanto desde el técnico y el punto de vista financiero.

• AWS es compatible con una amplia variedad de casos de uso cuando se combina con otras soluciones de gestión de datos.

• Buena experiencia del cliente y rápida penetración en el mercado.

Inconvenientes

• Una competencia cada vez mayor en las capacidades funcionales y opciones en la nube para elegir.

• Como AWS es un proveedor en la nube, carece de soporte para las combinaciones de almacenamiento de datos.

• AWS maduran en el uso de Redshift, y se están empezando a reportar limitaciones en relación a sus expectativas para la gestión mixta de carga de trabajo.

Cloudera

Cloudera proporciona una plataforma de almacenamiento y procesamiento de datos basado en el ecosistema Apache Hadoop, así como las herramientas del sistema de propiedad y de gestión de datos para el diseño, implementación, operación y gestión de la producción.

Ventajas

• Cloudera se diferencia de otros proveedores de distribución de Hadoop en que sigue invirtiendo en capacidades específicas, tales como mejoras adicionales como Cloudera Navigator (que proporciona la gestión de metadatos, linaje y la auditoría), mientras que al mismo tiempo trata de mantenerse al día con el proyecto de código abierto Hadoop.

• Cloudera ha colocado con éxito su solución como complemento al almacén de datos tradicional y ha hecho uso de sus relaciones con los proveedores de DBMS tradicionales, sobre todo de Oracle.

• Cloudera ha continuado su expansión geográfica.

• La modularidad Hadoop permite añadir nuevos componentes fácilmente, y Cloudera continúa expandiendo su conjunto de componentes para cumplir con los nuevos casos y las necesidades de uso. Esto permite a Cloudera ofrecer nuevas capacidades sin interrumpir los sistemas existentes.

Inconvenientes

• A pesar de que las organizaciones tienen un interés cada vez mayor en implementaciones en la nube, Cloudera se refiere a la nube utilizando un enfoque de infraestructura como un servicio que no ofrece soporte de servicio escalable, elástico y administrado. Sin embargo, Cloudera se dirige a estas necesidades con mejoras para facilitar la implementación de clusters elásticos en la nube.

• Se considera que la disponibilidad de recursos de apoyo de servicios se está reduciendo. Cloudera ha reconocido que esto es un problema, y ha trabajado para abordar estos puntos en 2015.

Exasol

Exasol ofrece una columna de memoria de DBMS, que está disponible como un solo nodo libre, una solución agrupada. También se ofrece como una solución completamente gestionada en EXACloud y los proveedores de servicios cloud de terceros, tales como AWS, Microsoft (Azure) y Rackspace.

Ventajas

• Exasol introdujo el desarrollo virtual del esquema (para fuentes de datos externas) y el uso de contenedores de lenguajes de guiones, junto con la distribución paralela existente. Esta combinación permite desarrollar, desplegar y ejecutar algoritmos de análisis desarrollados por los clientes sobre Exasol en cualquier idioma (por ejemplo, R, Scala, Java, Python y Lua).

• Buena relación calidad-precio de EXASOL. Se aprecian sus resultados.

Inconvenientes

• Exasol sufre de una falta de visibilidad en el mercado. Exasol redujo sus operaciones de Estados Unidos en 2015.

• Falta de capacidad de despliegue y gestión del ciclo de vida, como la reducción del tamaño del clúster y la funcionalidad de cliente de SQL.

• La documentación es a veces insuficiente y la disponibilidad limitada de las habilidades del mercado dificulta la adopción.

Hitachi

Hitachi entró en el mercado de almacenamiento de datos y DMSA en 2014 con la avanzada Carpeta de Datos de Hitachi (HADB). Se ofrece en tres configuraciones, incluyendo escritorio, modelo de "entrada" y el modelo "estándar".

Ventajas

• HADB posee una alta velocidad, soluciones para el análisis de datos estructurados tradicional combinado con datos de sensores con un enfoque en casos de uso industriales.

• Grandes volúmenes de datos comerciales, incluso los datos de sensores y datos geológicos estructurados con datos para el análisis con HADB. Hay una opción de HADB llamada "fuera de servicio" en la que la ejecución, no pasa por las operaciones tradicionales, síncronas lo que aumenta el grado de paralelización de los procesos de E/S.

• Autosuficiencia y facilidad de acceso a los registros de seguimiento.

Inconvenientes

• Hitachi ofrece una solución madura, eficiente, pero a veces básica para el almacenamiento de datos.

• Hitachi tiene sólo un pequeño número de referencias de producción.

• El posicionamiento de HADB de Hitachi se centra en análisis de alto rendimiento para grandes volúmenes de datos estructurados y no aborda, por sí mismo, el enfoque de LDW. Sin embargo, Hitachi comercializa su adquisición Pentaho como una alternativa al enfoque LDW que se ha establecido en el mercado.

Hortonworks

Hortonworks ofrece una plataforma de datos Hortonworks (HDP) en Linux y Windows. También ofrece Hortonworks DataFlow (HDF) en Linux en una base local y a través de varios proveedores en la nube. Hortonworks con Microsoft (por su servicio Azure HDInsight) para implementaciones híbridas locales y en la nube.

Ventajas

• Hortonworks ha ganado fuerza de mercado con un mayor número de socios reconocidos, incluyendo proveedores tradicionales de DBMS.

• Hortonworks con la plataforma Open Data es compatible con el crecimiento de nuevos proyectos de la Fundación Apache. Hortonworks se diferencia de otros proveedores de distribución mediante la adopción de código abierto.

Inconvenientes

• Será un reto para Hortonworks mantener la integración con un ecosistema de análisis más amplio, como Teradata.

• Incluso con la deriva de la demanda hacia soluciones de código abierto, no seleccionan sólo proveedores o soluciones en base a este único aspecto.

HPE

Hewlett Packard Enterprise hace frente a soluciones de gestión de datos para análisis, HPE Vertica, se basa en el núcleo Vertica DBMS. Está disponible como solución en la nube, como una opción de sólo software y como máquina física. Ofrece integración con Hadoop con HPE Vertica para SQL en Hadoop.

Ventajas

• HPE Vertica tiene una alta relación calidad-precio. Esto lo diferencia de otros proveedores.

• HPE Vertica posee una gran variedad de casos de uso y tipos de datos.

• HPE Vertica abastece a las principales tendencias del mercado, con soporte para la prestación en la nube, el LDW (con Vertica SQL en Hadoop) y ricas capacidades de análisis de bases de datos.

Inconvenientes

• Poca visibilidad del producto en el mercado.

• Problemas con la administración y la gestión de los DBMS de HPE, aunque se está mejorando gradualmente.

• HPE OnDemand ofrece un conjunto de gestión de datos en la nube y servicios de análisis, pero es independiente de la oferta Vertica, y como resultado demuestra una estrategia fragmentada a través de los dos.

IBM

IBM ofrece soluciones DBMS independientes, dispositivos de almacenamiento de datos, una solución z/OS, y una distribución de Hadoop con BigInsights. Sus máquinass incluyen el sistema PureData IBM para Analytics y para análisis de operaciones, el acelerador IBM DB2 Analytics (IDAA) y el IBM Smart Analytics System. IBM ofrece IBM DB2 con aceleración Blu, así como servicios gestionados de almacenamiento de datos.

Ventajas

• IBM ha lanzado dashDB y DataWorks como ofertas en la nube. Estos ofrecen la oportunidad de desplegar rápidamente modelos analíticos y de datos en un entorno elástico. Se dirigen a la creciente demanda de soluciones en la nube.

• IBM ha introducido dispositivos de conexión a fuentes relacionales y NoSQL. Se permite el acceso al procesamiento a través de una amplia variedad de entornos.

• IBM con el proyecto de código abierto Apache Spark añade valor a los productos de IBM por streaming que permite, aprendizaje automático y análisis avanzados. Puede ayudar a una maduración más rápida de Spark.

Inconvenientes

• El nivel de adopción de dashDB es incierta.

• La reducción de personal de IBM reposiciona su oferta para el mercado de soluciones en la nube y de gestión de datos modernos.

• IBM queda en el tercio inferior de relación calidad-precio. Los productos en la nube de IBM no tienen un precio competitivo.

Infobright

Infobright es una compañía global que ofrece una columna con vectores, DBMS altamente comprimidos con MySQL- o una capa API basada en PostgreSQL. Se comercializa el comercial Infobright Enterprise Edition (EEI), para los cuales hay una descarga de prueba.

Ventajas

• La velocidad de procesamiento es el diferenciador de Infobright. Sus tasas de compresión, carga y ausencia de necesidad de indexación.

• Reducción de compromisos hacia los productos que se determinaron como insostenibles en términos de costo.

• Internet de las cosas (IO) presenta una clara oportunidad para Infobright, y planea diversas innovaciones tecnológicas en esta área. Se ha aumentado su carga distribuida de procesador (DLP) para dar cabida a la ingestión corriente, que es fundamental para la adopción de la IO. También ofrece oportunidades en áreas relacionadas como telecomunicaciones y redes.

Inconvenientes

• Algunos tipos de datos MySQL no son compatibles con el software de Infobright, pero esto puede reflejar el uso de diferentes versiones. Ausencia de ciertas características (como limpieza de las tablas), y el proceso de actualización de versiones que se considera engorroso.

• Floja penetración del mercado de la IO de Infobright aunque parece estar haciendo las adaptaciones adecuadas.

Kognitio

Kognitio ofrece la plataforma analítica Kognitio tanto como un motor DBMS de almacén de datos de software y como máquina física. Kognitio ofrece una solución en la nube con Kognitio Analytical Services; También está disponible en la nube pública de AWS.

Ventajas

• Kognitio permite ejecutar soluciones de análisis tradicionales, como mercados de datos y almacenes de datos, junto con distribuciones de Hadoop (incluyendo el motor de análisis de Kognitio para los datos que residen en Hadoop) en una sola gestión de datos para el entorno de análisis - el LDW.

• Con planes de mejorar la convivencia en los nodos de Hadoop y la integración con Apache Hadoop y Kerberos, así como análisis de JSON, Kognitio probablemente aumente su atractivo como motor de procesamiento universal para el procesamiento de análisis distribuido.

• Kognitio se centra en gran parte en la tecnología. Además, se adapta a las nuevas demandas de los clientes de última generación, tales como las que requieren un motor analítico sobre las distribuciones de Hadoop. Esto incluye secuencias de comandos externos para apoyo, Python, Java y C para mejorar la distribución de los enfoques de tratamiento.

Inconvenientes

• Es difícil encontrar personas con conocimientos de Kognitio, sobre todo debido a que es una empresa de pequeño tamaño y su solución está poco implantada.

• Falta de integración con muchos productos de terceros BI y de datos.

• Problemas de administración de bases de datos, tales como la gestión de memoria. Además, observaron que la interfaz de usuario administrativa, se debe mejorar.

MAPR

MAPR Technologies ofrece una distribución de Hadoop con rendimiento y almacenamiento optimizado, mejoras de alta disponibilidad y las herramientas administrativas y de gestión.

Ventajas

• MapR posee alta disponibilidad y gestión de clusters. MapR ha mejorado estas capacidades con la adición de funciones de autorización y auditoría.

• MapR se centra en abordar una amplia gama de casos de uso. Es compatible con streaming, casos de uso operativos y analíticos, todo desde la misma plataforma, con el apoyo y capacidades de SQL.

• MapR se ha estado expandiendo por todo el mundo. Dispone de soluciones conjuntas con los principales actores, como AWS, Google, HPE, IBM, Microsoft, SAP, SAS y Teradata.

Inconvenientes

• Todavía carece de una falta de visibilidad en el mercado.

• En general poco avanzado. Los usuarios crean los análisis que se implementan como productos de datos completos para su uso en producción.

• Problemas con actualizaciones e instalaciones. Para hacer frente a estos retos, MapR ahora ofrece a los instaladores interfaz gráfica de usuario, libros de utilización, un instalador de parches y paquetes de actualización.

MarkLogic

MarkLogic ofrece una base de datos NoSQL que utiliza XML, JSON, texto, Resource Description Framework (RDF) y almacenamiento binario, proporciona una capa de gestión de entidad semántica basada en metadatos. El producto incluye índices, almacenamiento por niveles, apoyo Hadoop Distributed File System (HDFS), soporte de Amazon S3, replicación móvil, búsqueda de texto completo, capacidades geoespaciales, y SQL / ODBC de apoyo.

Ventajas

• Mejoras en el producto, mejor posición en capacidad de ejecución.

• Útil cuando se trata de trabajar con diversas formas de activos de datos semiestructurados (y otros más estructurados). Introducción de estadísticas de casos de uso y cómo se relacionan con los datos bajo gestión, Aumento de las capacidades administrativas y de diseño de MarkLogic.

• MarkLogic como capa de datos se apoya en la entrega de datos en arquitecturas e implementaciones centradas en servicios Web. Soporte para la atomicidad, coherencia, aislamiento y durabilidad (ACID) en NoSQL y completo integración e indexación de texto.

Inconvenientes

• MarkLogic es un pequeño proveedor.

• Falta de expertos especializados en MarkLogic, lo que representa un riesgo para las implementaciones de usuario. Brechas de funcionalidad (falta de declarativa) y falta de herramientas maduras de gestión / administrativas.

MemSQL

MemSQL ofrece un DBMS en memoria para casos de uso transaccionales, combinado con una columna basada en disco para la analítica.

Ventajas

• La estrategia de MemSQL se centra en el apoyo a los casos de uso transaccional y analítico con requisitos de baja latencia. Su integración con Spark Apache permite el procesamiento de transacciones y análisis.

• Posee almacén de datos y DMSA abordando análisis de operaciones.

• Su tecnología es bastante flexible.

Inconvenientes

• Mala relación calidad-precio. Sin embargo, MemSQL ofrece una edición gratuita y no cobra por el almacenamiento en disco en su almacén.

• Poca demanda en el mercado DBMS operativo.

• La oferta de MemSQL se puede utilizar sólo para casos de uso de análisis, como de almacén de datos tradicional.

Microsoft

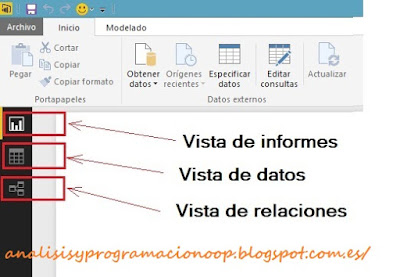

Microsoft SQL Server comercializa, una arquitectura de referencia, el Sistema de Plataforma Microsoft Analytics (que combina SQL Server Parallel Data Warehouse y HDInsight), una oferta en la nube con SQL Azure de almacenamiento de datos y HDInsight para Hadoop.

Ventajas

• Las soluciones basadas en la nube de Microsoft incluyen un entorno de análisis de datos con SQL Azure Data Warehouse. Aunque el almacenamiento de datos de SQL Azure se encuentra todavía en vista previa. Además, las amplias opciones para el despliegue y el enfoque "solución completa" de Microsoft suponen un reto para los proveedores tradicionales con fortalezas en capacidades en la nube y experiencia de usuario y autoservicio.

• Microsoft Azure ofrece consulta y aprendizaje automático Azure. Introduce un ambiente cada vez mayor de gestión de datos de análisis de auto-servicio para los usuarios de Microsoft. Con la disponibilidad adicional de Data Lake y Azure Data Analytics Lake.

• Se elogia su seguridad, la escala y la familiaridad. T-SQL se convierte en una característica polybase para el análisis de datos estructurados y no estructurados, que incluye R e interoperabilidad con funciones de fuente abierta en base de datos R. SQL Server 2016 es compatible con las implementaciones en las instalaciones combinadas en la nube.

Inconvenientes

• Cuestiones de infraestructura ocasionales y poca funcionalidad en recuperación de desastres, la integración de SMP y MPP, y la plataforma de problemas de gestión de exposiciones y despliegue.

• No está claro el posicionamiento de Microsoft para las soluciones de gestión de datos para el análisis en la nube.

Más información en